BET体育365投注官网院讯(通讯员:孙晓倩)近日,并行和分布式系统研究领域国际顶级期刊IEEE Transactions on Parallel and Distributed Systems(IEEE T-PDS)接收我院学术论文(Xu Ma, Xiaoqian Sun, Yuduo Wu, Zheli Liu, Xiaofeng Chen, Changyu Don. Differentially Private Byzantine-robust Federated Learning, 2022)。该论文以马旭副教授为论文第一作者,2020级研究生孙晓倩为论文第二作者。IEEE Transactions on Parallel and Distributed Systems是中国计算机学会(CCF)推荐的A类期刊,中科院分区2区,最新影响因子为2.687。

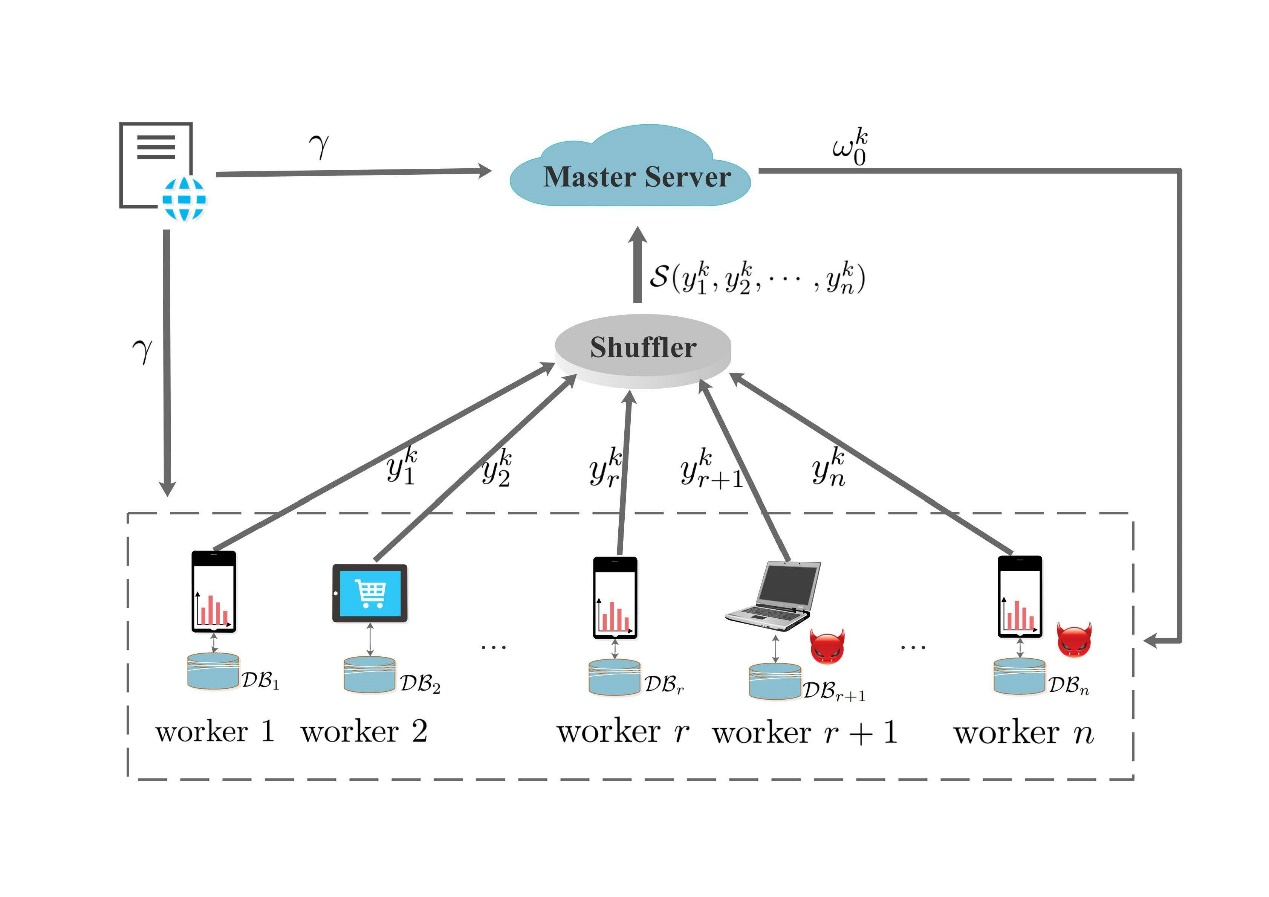

联邦学习作为分布式的机器学习范式,可以有效解决数据孤岛问题,让参与方在不共享数据的基础上联合建模。然而,已有研究表明,联邦学习不能完全保证模型训练过程的安全性和隐私性。首先,联邦模型的训练涉及到参与者本地更新和全局模型参数的交换,攻击者窃取到这些参数会为模型逆向攻击、成员推断攻击和模型提取攻击等隐私攻击提供知识,造成严重的隐私泄露风险;其次,拜占庭攻击者可以控制一部分参与者,通过发送恶意参数执行中毒攻击,严重损害联邦模型的鲁棒性。在联邦学习的研究中,已提出很多方案来解决隐私和鲁棒问题,但是同时解决这两个问题仍十分具有挑战性。针对这个挑战,本文设计了一个高效的求和洗牌协议(SPS),并在此基础上提出了一个差分隐私约束下的拜占庭鲁棒联邦学习方案(DPBFL),该方案具有较高的计算和通信效率。最后本文通过严格的理论分析和在MNIST、FashionMNIST和CIFAR10数据集上的实验结果表明,DPBFL能够有效的保护联邦学习的隐私性和鲁棒性。

该研究得到了国家自然科学基金的资助。